TuringTechTalk #34「E2Eモデルの進化と、2026年の目標」

はじめに

チューリングのEnd-to-End(E2E)自動運転は、モデルの完成度だけでなく「実車で動く」「改善が回る」フェーズへと進み、開発の重心が“理論”から“実装とスケール”へ明確に移り始めています。

今回のテックトークでは、CTOの山口と、自動運転開発の現場を統括する棚橋が登壇。E2E自動運転の基本から、車載計算機とカメラ中心の構成、車両制御・データ収集・評価という“氷山の下”のリアル、そしてTokyo30(東京都内30分無介入走行)達成の裏側まで、現場目線で解き明かします。

※本記事はTuringTechTalk#34の内容を元に一部編集してお届けします。

平和島から始まる2026年

山口: 皆さんこんにちは。チューリングCTOの山口です。TuringTechTalk第34回、「E2Eモデルの進化と2026年の目標」を始めます。今日はチューリングの自動運転開発を現場で牽引している棚橋さんに来てもらっています。棚橋さん、よろしくお願いします。

棚橋: よろしくお願いします。

山口: まず雑談から入るんですけど、拠点が大崎から平和島へ移って、配信環境も含めて色々変わりましたよね。現場として平和島の環境、どう受け止めてます?

棚橋: 想像以上に良いです。天井も高いし、同じ空間を全員で共有できて、コミュニケーションも取りやすい。あと地味に嬉しいのが社食ですね。月曜から木曜まで毎日出て、クオリティが高いです。

山口: そうそう。研究開発って、机とPCだけあれば進むようでいて、実は「同じ場所で同じテンポで会話できる」だけで速度が上がることがある。平和島に移って2週間ちょっとですが、そこは私も満足してます。

E2E自動運転とは

山口: 今日はE2E自動運転の話を、モデルだけじゃなくて、実車で成立させるところまで含めて話したいです。まず前提として、棚橋さん、E2E自動運転って一言でいうとどういうものですか?

棚橋: 従来の自動運転は、センサーやHDマップを前提に、パーセプション(認識)→プレディクション(予測)→プランニング→コントロール、みたいにモジュールを分けて組み合わせる構成が多かったと思います。E2Eはそれを分解せず、単一のニューラルネットワークにカメラの画像や映像を入れて、車をどう動かすかというアクションを直接出力します。

山口: ありがとうございます。従来の自動運転ではWaymoなどが有名ですが、最近はE2Eという言葉を聞くこともかなり増えてきましたよね。

棚橋: そうですね。あと、最近E2Eが注目されたタイミングって、LLMが一般化したタイミングと少し重なっていると思っていて。LLMも、複雑な質問に答えるとき、内部でルールを手書きしているわけじゃなく、大量データで学習して成り立っている。E2Eも似ていて、「次のアクションを予測するだけで複雑な運転ができるの?」って直感に反するんですけど、データが増えるほど、人間が考えているかのような運転が出てくる感覚があります。

山口: 歴史の話で言うと、2016年頃にNVIDIAがDAVE-2を出していて、CNNベースで「画像→ステアリング」みたいなE2Eの芽は昔からありました。ただ当時は、レーンキープ的なところが中心で、都市の複雑なネゴシエーションまで飲み込むフェーズではなかった。ここ数年でモデル・データ・計算の条件が揃って、ようやく“勝負になる”土俵ができた、という見方もできます。

見えてるのは氷山の一角、E2Eを実写で動かす勝負は水面下

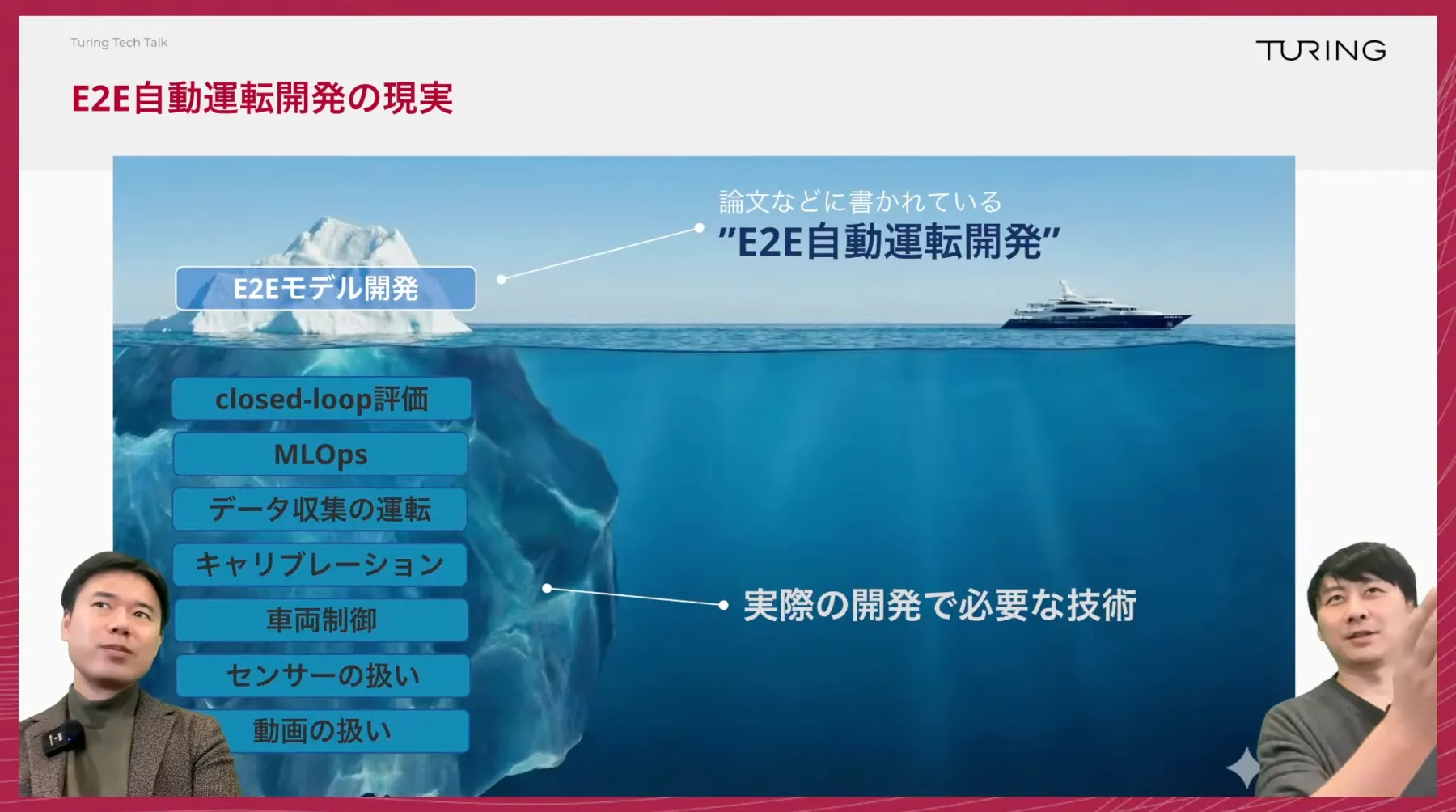

山口: ここからが今日の肝です。AI DAYでも「氷山」のスライドを出しましたが、E2Eって「モデル作れば走る」と思われやすい。でも現実は逆で、モデルは氷山の上に見えてる部分で、下が圧倒的に大きい。

棚橋: まさにそうで、E2Eモデル開発って言っても、実際に車を走らせるには別の技術が必要になります。例えば、センサーの取り扱い、動画データを作る、運転アクションを作る、車両制御の遅延や追従性を詰める、評価する、クローズドループで回す、みたいな話ですね。

山口: 自動運転はリアルタイム性が厳しい。LLMみたいに「数秒待って返ってくる」が許されない。0.1秒の遅れが命取りになる。だから、AIの賢さだけでは閉じず、車載ソフトウェアとハードウェアの整合が必須になる。

棚橋: もう1つ大きいのが評価です。公道走行で評価すると、同じシナリオが再現できない。時間帯で交通状況も変わるし、同じ交差点でも歩行者の出方が違う。モデルAとモデルBの差を見たいのに条件が揃わないので、「どっちが良いのか」を定量で判断しにくい。シミュレーターやクローズドループ評価についても、現実と同じ再現性を持って行うことはかなり難しいです。

山口: “E2Eの難しさ”って、モデルの数式よりも、現実の制約を飲み込むエンジニアリングにある。ここを理解してもらえると、チューリングの仕事の面白さが伝わると思います。

Orin 250TOPS、そして車両を増やしてデータを増やす

山口: では車両の話に入ります。チューリングの車両はアルファードベースで、外から見るとカメラがさりげなく付いている。計算機は1台でまとめてます。棚橋さん、計算機のスペックを改めて。

棚橋: NVIDIAのOrinを使っていて、だいたい250TOPSぐらいですね。

山口: 最新のGPUアーキテクチャと比べると古い部分もありますが、当時は選択肢が少なかったこともあり、車載でE2Eを回す前提で採用しています。自動運転領域ではかなり一般的なSoCですね。ここで重要なのは、車両が1台じゃないことです。29号車まで同じ構成を作って、データ収集もできるし制御もできる。なぜ同じ構成を増やすかと言うと、結局E2Eはデータが勝負だからですね。そして、チューリングでは同じ車両をデータ収集と制御の両方に使用できるんですよね?

棚橋: そうですね。データ収集専用にしてしまうと、制御実験の速度が落ちる。逆に制御用だけだとデータが増えない。なので同一車両で両方できるのが開発上は効きます。

山口: そして“ゴツい自動運転車”のイメージと違って、計算機1個でかなりコンパクトにまとめている。量産を見据えると、この方向性が大事にりますね。

AI以前に「車が思い通りに動かない」

山口: 開発の振り返りをすると、最初はモデル以前に「車が動かない」という壁がありました。2024年10月頃のクローズドコースでの検証、まずはラインに沿って走らせるところからでしたよね。

棚橋: はい。最初はMLモデルを入れずに、単純にコースに従って走れるかを検証しました。そもそも車をプログラムに従って動かす、というだけで難しかったので。そこから自動運転モデルと結合していく形です。

山口: ガソリン車だと縦制御が難しい、という話もありました。棚橋さん、理由をもう少し噛み砕くと?

棚橋: 低速域でこちらが加速度を渡しても追従性が高くなく、縦制御が安定しない。車両側にブラックボックス的な制御が入っていたり、アクチュエータの反応速度や遅延も絡むので、思った通りの動きにならない。ハイブリッドだとモーターが効いて滑らかに制御しやすい、という差もありました。当時は毎日、絶望しては解決されて喜ぶ、の繰り返しでしたね(笑)。

山口: この壁を越えて、AIの改善がちゃんと走行性能に反映される“土台”ができましたね。

モデル設計の方針

山口: 次にモデルの話。今のE2Eモデルは、イメージバックボーン→Transformer→トラジェクトリー出力という、比較的シンプルな構造です。ここで話題になるのがBEV(Bird eye view)やオキュパンシー、UniAD※みたいな複雑設計との違いですよね。

※CVPR2023でBest Paper Awardを受賞したUniAD [Yihan Hu+, CVPR2023]

棚橋: 我々がBEVに強く寄せていない理由はいくつかありますが、1つはデバッグ性です。複雑な構成だと、走らなかったときにどこが悪いのか追いづらい。もう1つは開発資産の継続性で、普通のコンポーネントで組んでおくと、高速化やチューニングのノウハウが積み上がって、次のモデルにも引き継げる。

山口: モデルの工夫でちょっと性能を上げるより、データを増やし、スケールに耐える構造で伸ばす方が、最終的に勝ちやすい。

棚橋: はい。モデル改善はあるにせよ、古典的に「アーキテクチャをこねて勝つ」より、データの質量が支配的になっている感覚はあります。

都内で“人間っぽい”挙動が出始めた瞬間

山口: 2025年の春頃には、クローズドコースでもかなり自在に操れる状態になってきて、そこから公道で安定して走れるようになりました。平和島から大崎のルートを走る映像、あれは2025年8〜9月頃でしたよね。

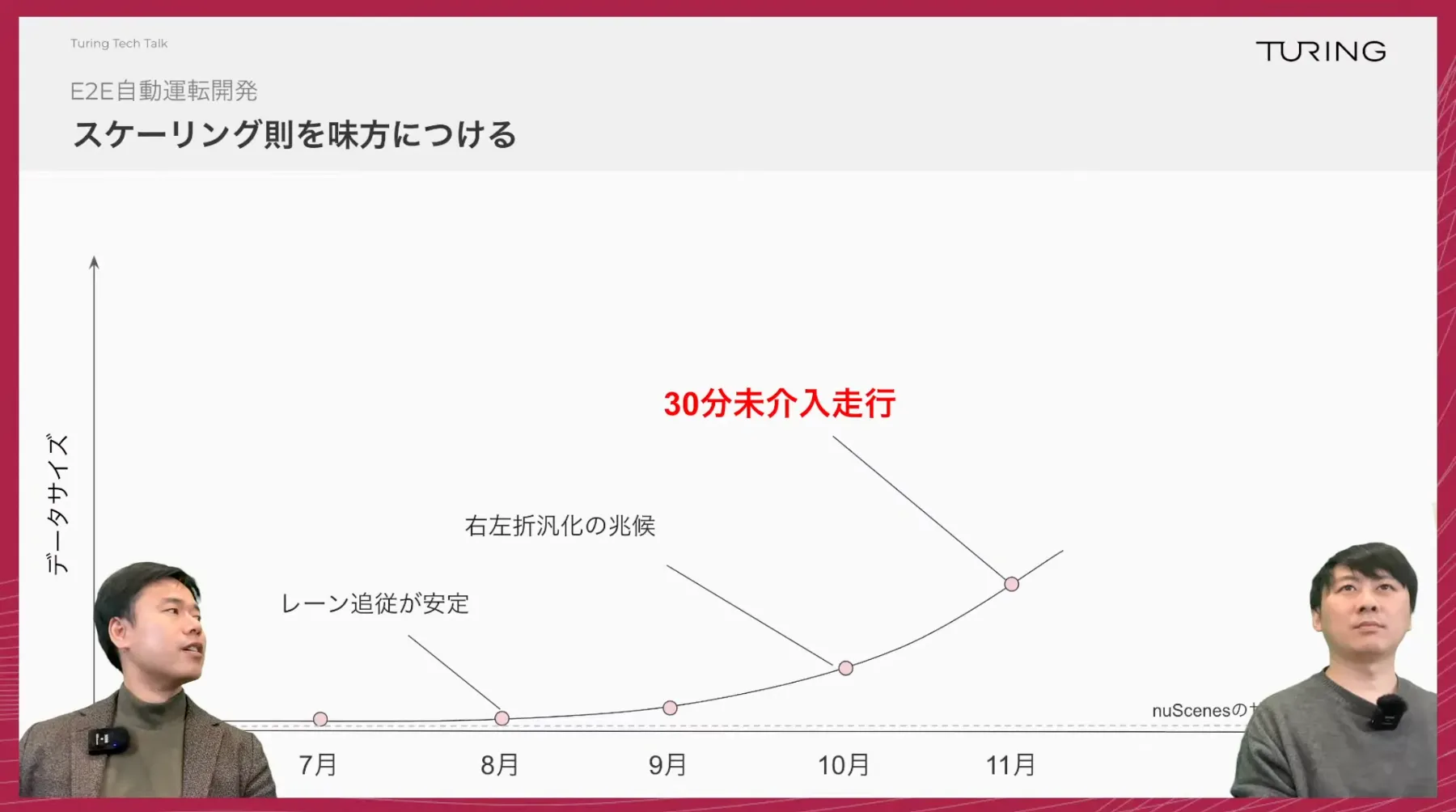

棚橋: そうですね。その頃には、信号で止まる、右左折する、レーンチェンジする、みたいな基本動作が滑らかになっていました。面白いのは、山道みたいな比較的シンプルな環境も十分凄いんですが、データを増やしていくと市街地みたいな複雑環境でも人間っぽい“創発”が出始めることです。例えば、信号待ちで車が詰まっていたら空いてる車線にスッと移って前に出る、とか。

山口: こういう挙動って、ルールで書くと沼なんですよね。でもE2Eだと、データが積まれるほど自然に出てくることがある。

カンブリア爆発の正体

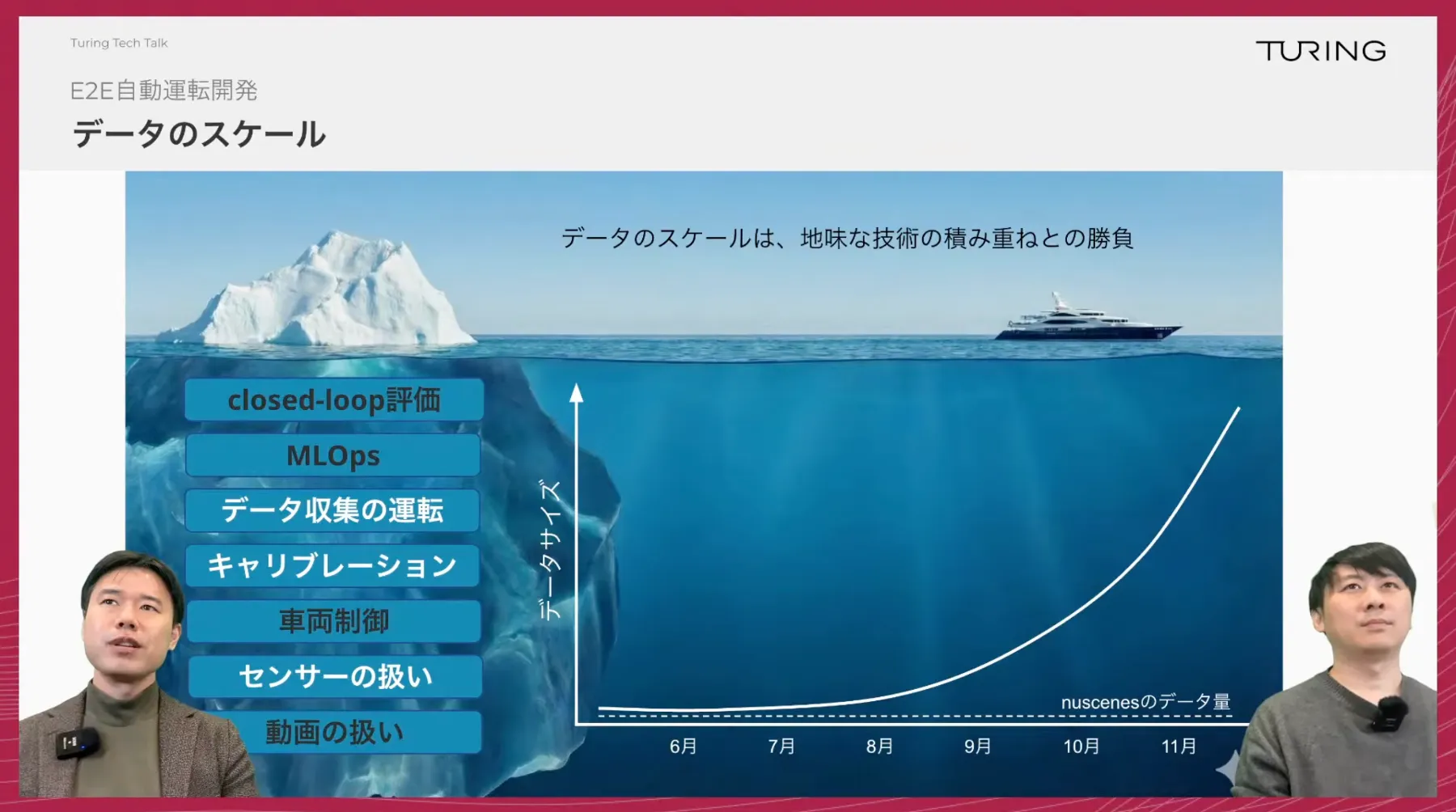

山口: ここでデータの話。最初は単一号車・単一ドライバーで検証して、そこから複数車両・複数ドライバーへ拡張しました。データを増やすと、センサー差分や運転スタイル差分を吸い込む必要が出てきます。

棚橋: そのためにキャリブレーションを揃えたり、データパイプラインを整備したり、地味だけど重い作業が必要になります。ここが氷山の下の部分ですね。

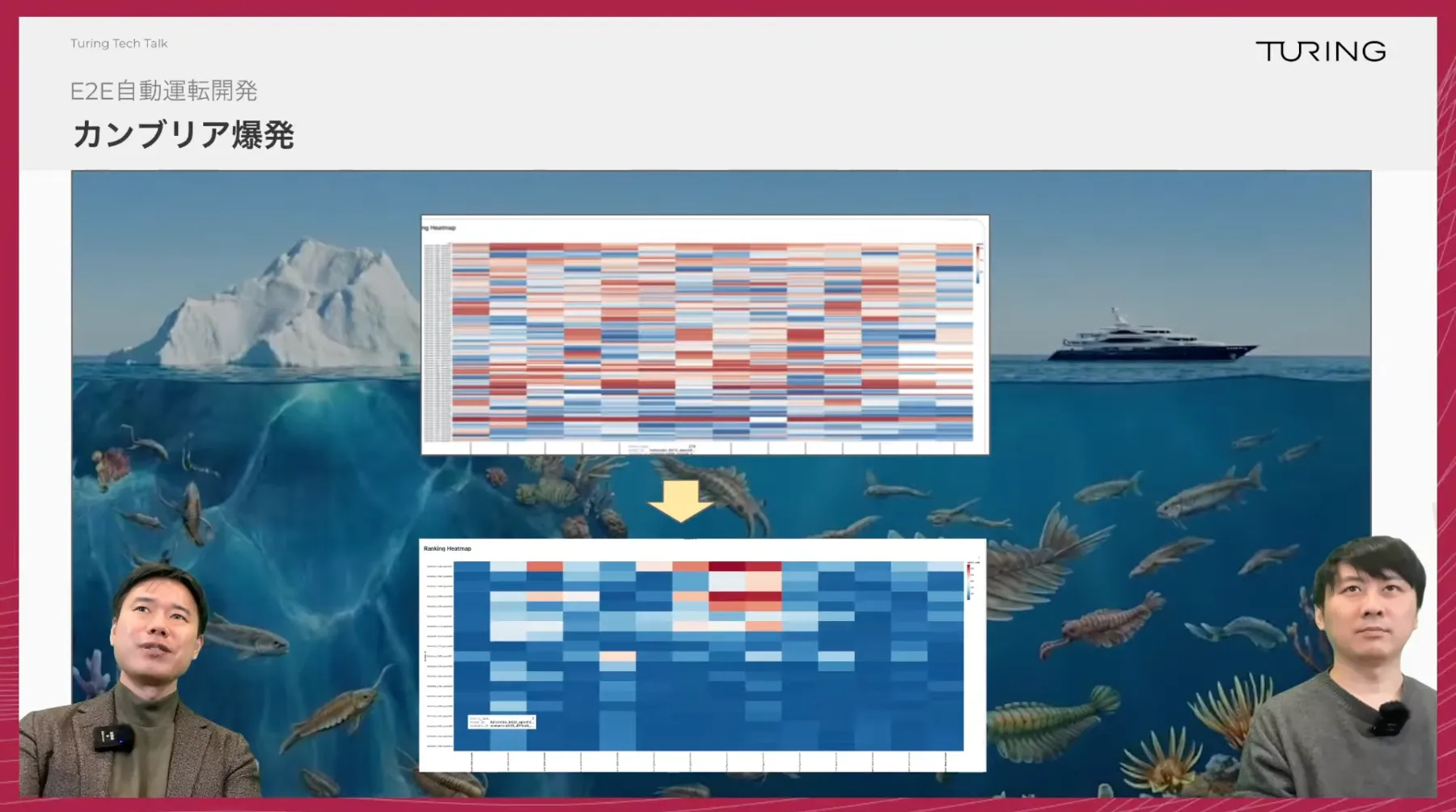

山口: そして、ある時期にモデルの評価指標が一気に青くなった。社内では“カンブリア爆発”と呼びました。

棚橋: AIの進化ってリニアじゃなくて、ある日突然来るんだな、という体験でした。データがあるラインを超えたときに、モデルが急に“粘り強く”なった感覚があります。

E2E自動運転が強いシーン

山口: 具体例を挙げると、対向車を見ながら中避けするネゴシエーション、歩行者が大量に渡る横断歩道、マリオカート風の小型車両、工事現場の誘導員のジェスチャー。こういう「抽象度の高い情報」が混ざる環境で、E2Eが強みを見せることがある。

棚橋: 特に特殊車両は面白いですね。学習データにほとんどないはずなのに、車間を空けて止まって、全部行ったら後ろに付いていく、みたいな挙動が出た。モジュール型だとカテゴリ定義が必要になるので、そこを“映像のまま”処理できるのはE2Eならではです。

山口: もちろん万能ではない。だからこそ、データと評価を回して、こういうシーンを着実に潰していくのが2026年の勝負になりますね。

Tokyo30達成と、“回る開発”の完成度

山口: Tokyo30、東京都内30分無介入走行は大きな節目でした。引き金はデータスケールで、9〜11月にデータが増えて、11月に“閾値”を超えた感覚がある。

棚橋: そこに加えて、MLOps基盤が効きました。データを集め、前処理し、データセット化して、GPUクラスターに転送し、学習し、デプロイして走行実験して、結果をまた学習に戻す。このループを自動化して回せるほど、改善の速度が上がります。

山口: そして評価。クローズドループ評価がようやく実用になってきた。3DGSで空間を再構成し、モデル出力で車を動かして、車線逸脱や曲がり損ねを定量化できる。現実の制御アルゴリズムまで組み込むのが難しいけど、最近かなりうまくなってきた。

棚橋: はい。最初は3DGS空間を作るだけでも難しかった。でも最近は再構成も安定してきて、フィジックスや制御まで含めて“実験と同じ走り”を再現できるようになってきた。評価が回ると改善が回るので、ここは大きいです。

山口: 配信でも質問がありましたが、LiDARはどうですか?

棚橋: 収集時に教師ラベル用途で付けていた時期はありますが、結論として今は自動運転入力としては使っていません。

山口: そうですね。もう外してます。カメラ中心で成立させる設計に寄せています。

2026年の目標は、より複雑な東京で、より安定に、ナビ連携も現実へ

山口: 最後にタイトル回収です。2026年の目標を、棚橋さんの言葉でまとめると?

棚橋: 30分走れたのはスタートです。2026年は、より複雑な都内で安定して30分無介入を出すこと。さらにナビゲーション連携を安定させること。周囲車両とのインタラクションも、より自然にしていく。ここが次の課題だと思っています。

山口: “できる”から“どこでも安定してできる”へ。地味で重い工程が増えるけど、チューリングはそこをやり切るために、データ・車両・評価・MLOpsを全部つないでいます。

Q&A一覧

以降は視聴者のQAに回答していきました。詳しくは動画をご覧ください。

- LiDARなどのセンサーも利用していますか?それとも画像認識とニューラルネットワークだけで制御していますか?

- 競合と比較して、初期から強みや差別化を意識した部分はありますか?

- E2Eモデルが出力するトラジェクトリーは座標集合ですか?速度の値も含まれますか?

- 学術界のE2Eモデルと産業で使われるE2Eモデルにはギャップがありますか?博士で研究しても無用になり得ますか?

- 量産車に適用する際の課題/自動車メーカーにお願いしたい領域はどこですか?

- 晴れ映像が多いが、夜や雨は難しいですか?

- ナビゲーション連携(NOA)実現の課題はどこにありますか?

- データが増える中で、学習は全データを使っていますか?サンプリングで一定量にしていますか?

- 歩道走行ロボットの起業家へ、これから自動運転に挑む企業家へのアドバイスは?

- ハイブリッド構成(E2E+モジュール)/ニューラルシンボリックは研究・実用で使われていますか?

- お台場・有明の映像が多いが、そのエリアのデータだけで学習しているのですか?

- アルファード改造にメーカー許可は必要ですか?自分でもやってみたい

チューリングでは、完全自動運転の技術を共に創る仲間を募集しています。今日お話ししE2Eスケールアップチームはもちろんのこと、機械学習エンジニア、リサーチャー、ソフトウェアエンジニア、組み込みエンジニア、インフラエンジニアなど、非常に幅広いエンジニア職種で仲間を募集しています。ご興味のある方は、ぜひ採用ページをご確認ください。多様な職種がありますので、ご自身がどれに当てはまるか、ぜひチェックしてみてください。